[Webhacking] OWASP ZAP 실습

OWASP ZAP의 실습 환경은 이전 포스트를 참조하길 바란다.

[Webhacking] 자동 분석 도구 공격

자동 분석 도구를 사용하는 이유? 다음 네 가지 정보를 확인하기 위해서이다. 1. 서비스의 디렉터리 구조와 파일 정보 확인 ➢ 한 페이지씩 클릭을 해서 확인하기 힘들기 때문에 크롤링 기법으로

haerinn.tistory.com

1. 스파이더(Spider) 기능

➢ 특정 페이지나 디렉토리 우 클릭 후 “스파이더(Spider)” 실행

➢ 크롤링 기능으로 대상 URL의 웹 페이지 및 디렉토리 구조를 파악

➢ 스파이더 시 Passive Scan Rule에 따라 간단한 웹 취약점 결과 출력

대상 URL의 웹 페이지 및 디렉토리 구조를 파악할 수 있다.

passive attack의 결과로 나오는 alerts 정보를 확인할 수 있다.

2. 스파이더(Spider) 패킷 분석

프로토콜 통계를 보면, TCP 중에서도 HTTP의 비중이 높고, 그 중에서도 line-based text data 비중이 높음을 알 수 있다.

응답 패킷들의 상태 코드를 확인할 수 있는데, 대부분 200 OK 인 것을 알 수 있다.

-> 정상적인 페이지가 많이 찍힌 것을 통해 크롤링을 한 것임을 추측할 수 있다.

Bee-box ip의 정상적인 페이지에 대해 빠르게 크롤링한 것을 알 수 있다.

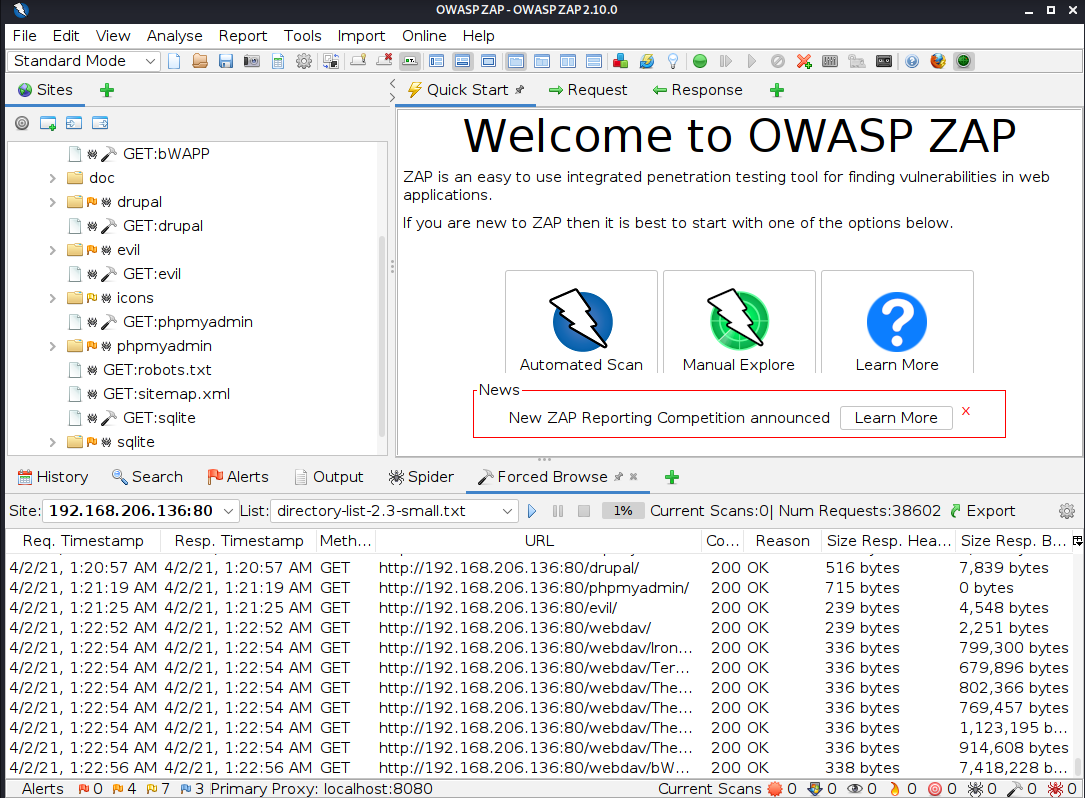

3. 강제 디렉터리 검색 이해와 패킷 분석

스파이더와 강제 디렉터리/파일 검사의 차이

- 스파이더 기능 : 크롤링 기능으로 대상 URL의 웹 페이지 및 디렉토리 구조를 파악

- 강제 디렉터리/파일 검사: 사전 대입으로 사이트 구조를 탐색 -> 스파이더 기능으로 발견하지 못한 페이지(관리자 페이지)나 디렉토리를 찾을 수 있음

dictionary list(사전 파일)을 2.3v으로 업데이트 함.

directory-list-2.3-small.txt 파일을 선택해서 실습을 진행함.

굉장히 많은 패킷들이 짧은 시간 안에 캡쳐됨을 알 수 있음.

스파이더 실행 시 캡쳐했던 패킷들과 달리 404 not found의 비율이 압도적으로 높음을 알 수 있다.

그에 비해 200 OK 페이지의 비율은 낮다.

스파이더와 달리 페이지에 대해 검색한 다양한 딕셔너리 파일들이 나옴.